Зачем сейчас следить за новостями спортивных дата-сетов

За последние пару лет спортивные дата-сеты перестали быть «игрушкой» для энтузиастов и превратились в стандартный инструмент для клубов, медиасервисов и беттинг-компаний. Обновления по лигам выходят уже не раз в сезон, а буквально каждую неделю: меняются форматы файлов, появляются новые метрики, поднимается частота обновлений лайв-данных, дорабатываются модели xG и pass maps. Поэтому к спортивным данным сейчас нужно относиться как к «продукту с релизами», а не как к статичному архиву результатов.

Если вы хотите купить спортивные даты-сеты по футбольным лигам, важно понимать не только прайс, но и то, как устроен весь цикл: от сбора событий с поля до визуализации графиков на дашборде. Ниже — структурированная инструкция, чтобы безболезненно войти в экосистему и не утонуть в обновлениях провайдеров.

Необходимые инструменты для работы с данными и графиками по лигам

Базовый технологический стек

Для работы с современными спортивными дата-сетами по лигам потребуется минимальный, но осмысленный стек инструментов:

1. Язык анализа данных: Python или R (в индустрии чаще Python).

2. Хранилище: PostgreSQL, ClickHouse или хотя бы файловая структура в S3/MinIO.

3. BI- или визуализационный инструмент: Power BI, Tableau, Metabase или Plotly/Dash.

4. Клиент для интеграции с внешним API: requests / httpx в Python, либо встроенные средства в вашем фреймворке.

Этого достаточно, чтобы подключиться к API спортивной статистики и аналитики по лигам, регулярно забирать данные и строить на их основе интерактивные графики.

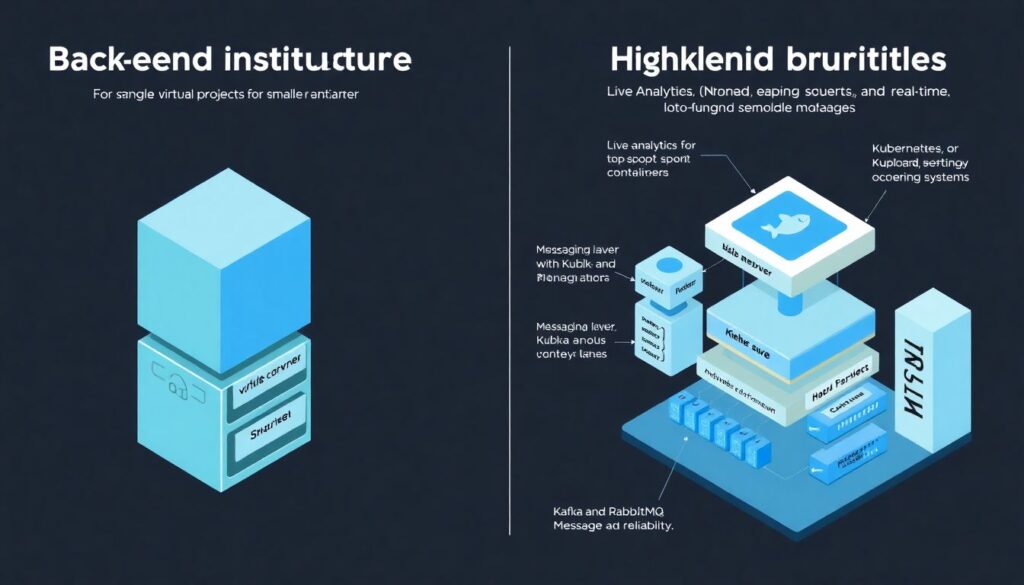

Инфраструктура и среда исполнения

Для небольших проектов подойдет один виртуальный сервер с Docker и системным планировщиком задач. Более нагруженные кейсы — лайв-аналитика топовых лиг, скоринг для беттинга, реалтайм-дашборды для медиа — требуют оркестраторов (Kubernetes, Nomad) и очередей сообщений (Kafka, RabbitMQ) для устойчивой обработки потоков событий.

Кейc: как медиа-сервис запустил дашборды по лигам за месяц

Один спортивный медиа-портал начал с очень простого стека: облачный PostgreSQL, Python-скрипты по cron, Metabase как визуализация. Первой задачей было не построить идеальную архитектуру, а разобраться, как именно поставщик данных и графиков для футбольных лиг отдает новые метрики (pressing intensity, зоны владения, прогрессивные передачи). Через месяц у них уже были базовые интерактивные графики по топ-5 лигам, а инфраструктура постепенно масштабировалась по мере роста трафика.

Поэтапный процесс: от подписки до работающих графиков

Шаг 1. Формулируем требования к данным

Прежде чем заключать договор или оформлять подписку на спортивные дата-сеты и статистику матчей, нужно формально определить требования. В техническом смысле речь идёт о:

— Частоте обновления (live, near-live, post-match).

— Типах лиг (топ-европейские, вторые дивизионы, молодёжные чемпионаты, женские лиги).

— Глубине исторических данных (3 сезона, 5 сезонов, больше).

— Уровне детализации: только события (голы, фолы, замены) или трекинг (координаты игроков, мяча).

Коротко: без спецификации вы рискуете получить либо «перебор» (платите за ненужный трекинг), либо дефицит (нет нужных лиг или метрик).

Шаг 2. Тестовое подключение к API

После выбора провайдера всегда начинайте с sandbox или тестового ключа. Цель — проверить:

1. Формат ответов (JSON/CSV/Avro, структура вложенности, ключи и типы полей).

2. Ограничения по rate limit.

3. Логическую целостность данных (нет ли пропавших матчей, дубликатов, разрывов по сезонам).

4. Стабильность API: как ведет себя сервис при пиковых нагрузках (туровые дни, дерби и плей-офф).

На этом этапе уже можно построить первые черновые графики: xG по матчу, shot maps, плотность атак по минутам. Это позволит быстро заметить аномалии — например, отсутствие координат для отдельных событий или некорректное время замен.

Кейс: провал интеграции из-за игнорирования тестового режима

Один стартап в сфере спорт-аналитики сразу подключил продакшн-ключ и стал забирать исторические данные целиком. Без тестового прогона они не заметили, что API отдает матчи в локальном времени стадиона и без явного часового пояса. В результате на дашбордах время начала матчей «прыгало» на несколько часов, а данные лайв-линий ставок не совпадали с реальным ходом игры. Исправление и повторный импорт заняли три недели.

Шаг 3. Проектирование структуры хранилища

Далее необходимо спроектировать схему хранения: матчи, команды, игроки, события, позиции, соревнования, сезоны. При работе с несколькими лигами уделите внимание нормализации айдишников и маппингу сущностей между поставщиками: один и тот же клуб в разных источниках может иметь разные идентификаторы и слегка отличающиеся названия.

Для масштабируемых проектов по разным странам удобно выделять три уровня:

1. Сырые данные (raw) — как пришли из API.

2. Нормализованные (core) — приведенные к общей схеме.

3. Агрегированные (marts) — витрины под конкретные задачи (беттинг, медиа, скаутинг).

Шаг 4. Построение пайплайна обновления

Автоматизируйте цепочку: запрос к API → валидация → запись в raw → трансформация в core → обновление витрин → обновление дашбордов. Типовой стек: Airflow/Prefect для оркестрации, dbt для трансформаций, BI-инструмент для визуализации. Важно сразу заложить логи и алерты по неуспешным запросам и несоответствию схемы.

Короткий практический совет: никогда не завязывайтесь напрямую из BI на API провайдера. Всегда используйте свое хранилище как буфер, чтобы не разрывать отчеты при кратковременных сбоях внешнего сервиса.

Шаг 5. Настройка визуализации и UX графиков

Финальный этап — превращение цифр в понятные графики. Стандартный набор: временные ряды (динамика xG, шоты по минутам), позиционные карты (heatmaps, pass maps), сравнительные графики по лигам (интенсивность прессинга, темп атак). Здесь важно учитывать профиль аудитории: беттинг-аналитикам нужен один набор метрик, журналистам — другой, тренерским штабам — третий.

Для межлигной аналитики пригодится нормировка показателей: темп лиги, среднее количество ударов, критерии «силы» команды. Это особенно критично, когда в игру вступает спорт аналитика данные лиг для букмекерских контор: некорректная нормировка резко портит качество моделей и маржу.

Кейсы из практики: как бизнесы используют свежие спортивные дата-сеты

Кейс 1. Медиа-портал: переход от статичных статей к интерактиву

Крупный спортивный портал начинал с текстовой аналитики по топ-5 европейским чемпионатам: статьи с инфографикой, подготовленной вручную. После подключения к новому провайдеру с расширенным набором событийнных данных по лигам (включая pressing events и progressive passes) они перестроили формат:

1. Автоматическая генерация карточки матча (xG, PPDA, зонированные шоты).

2. Лайв-обновление графиков в день тура.

3. Раздел с сравнением трендовых метрик по лигам: насколько, например, Серия А приблизилась по интенсивности к Бундеслиге.

Результат: рост времени на странице и увеличение конверсии в премиум-подписку. Ключем стали не сами данные, а регулярные обновления дата-сетов по ходу сезона — на каждое окно трансферов они публиковали новые графики влияния новичков на стиль игры.

Кейс 2. Беттинг-компания: перезапуск моделей и борьба с задержками

Средняя букмекерская контора решила сменить провайдера из-за лага по live-событиям и нехватки глубокой статистики для второстепенных лиг. После перехода на нового поставщика, специализирующегося на лайв-данных, выявились неожиданные нюансы:

— Лайв-данные стали приходить быстрее, но начали попадаться дубликаты событий.

— В некоторых азиатских лигах данные по карточкам приходили с задержкой 30–40 секунд из-за особенностей локального сбора.

Им пришлось пересмотреть пайплайн: добавить слой дедупликации, выстроить приоритетность источников (официальный фид vs. альтернативные каналы) и переработать сигналы триггеров для моделей. Зато итогом стали более устойчивые коэффициенты и снижение риска арбитражных стратегий игроков.

Кейс 3. Футбольный клуб: внутренняя платформа для тренеров

Один клуб из восточноевропейской лиги решил отказаться от разрозненных Excel-отчетов и внедрить единую платформу для тренерского штаба. Они выбрали гибкого поставщика, где можно было точечно купить спортивные даты-сеты по футбольным лигам, в которых участвовала основная и молодежная команды, плюс несколько турниров соперников в еврокубках.

Внутри клуба построили:

1. Единый каталог матчей и тренингов.

2. Дашборды по нагрузке и позиционной игре.

3. Модуль сравнения игроков — собственных и потенциальных трансферных целей.

Интересный побочный эффект: тренеры молодежки начали активнее использовать данные по «старшей» лиге, чтобы в режимах тренировок моделировать типичные сценарии, с которыми столкнутся игроки при переходе в основную команду.

Устранение неполадок и типичные проблемы

Несоответствие схемы и скрытые изменения в API

Одна из самых болезненных тем в новостях спортивных дата-сетов — «тихие» изменения в API и структурах полей. Провайдер может добавить новый тип события или поменять формат координат, не всегда синхронно обновив документацию. В продакшне это приводит к падению пайплайна или, что хуже, к незаметной порче данных.

Практическая защита:

1. Слои валидации схемы (jsonschema, pydantic models).

2. Контрольные тесты по количеству матчей/событий на тур.

3. Мониторинг доли null-значений по ключевым полям.

Проблемы с задержками и rate limits

Если вы ведете интенсивный опрос API во время тура, легко упереться в ограничение по запросам. Результат — пропуски событий или необходимость повторных запросов. Для лайв-аналитики это критично.

Короткий рецепт:

— Пакетировать запросы (batch endpoints, если доступны).

— Кэшировать статичные сущности (команды, игроки, турнирная сетка).

— Использовать backoff-стратегии и очереди задач, а не монолитный скрипт.

Кейс: как медиа-компания выловила баг по ходу сезона

Медиасервис, агрегирующий данные по нескольким лигам, заметил аномалию: в одном из туров резко упало среднее количество ударов по воротам в двух чемпионатах. Проверка видео показала, что сами матчи были обычными, а проблема крылась в изменившейся разметке «blocked shots». Провайдер сменил политику — часть блокированных ударов перестали относить к shot-событиям.

Команда за сутки переписала трансформации и пересчитала исторические отчеты с учетом новых правил классификации. Это хороший пример, почему нужно иметь версионирование витрин и возможность полноценно переигрывать исторические данные при изменении логики метрик.

Вопросы лицензий и прав на переиспользование

Помимо техники, частая «подводная» проблема — юридические ограничения. Не каждый поставщик разрешает отдавать агрегации третьим лицам, встраивать графики на сторонние сайты или использовать данные для моделирования коэффициентов. При выборе решения важно понимать, нужен ли вам только внутренний анализ, или предполагается публичная витрина и коммерческая переработка статистики.

Особенно тщательно изучайте условия, если вы — поставщик данных и графиков для футбольных лиг для других игроков рынка или интегратор, который строит на чужих данных свои SaaS-сервисы.

Как выбрать провайдера и не пожалеть через сезон

Критерии выбора и сравнения провайдеров

Чтобы не привязываться к первому понравившемуся сервису, имеет смысл формально сравнить несколько вариантов. Обратите внимание на:

1. Покрытие лиг и глубину истории.

2. Качество event- и tracking-данных (наличие координат, детализации событий).

3. SLA по доступности API и поддержке.

4. Политику изменений и прозрачность roadmap.

5. Условия лицензирования и ограничения по переиспользованию.

Соберите внутренний чек-лист и прогоните по нему каждого кандидата в режиме короткого пилота на одной-двух лигах.

Кейс: аналитическое агентство и мульти-провайдерная архитектура

Небольшое агентство, которое делало кастомную аналитику для клубов и СМИ, изначально работало только с одним фидом. Но как только клиенты попросили расширить охват до лиг Южной Америки и Азии, стало ясно, что ни один провайдер не покрывает всё одинаково качественно. Они пошли по пути мульти-провайдерной архитектуры: для Европы — один источник, для Латинской Америки — другой, для отдельных турниров — третий.

Ключевая задача стала не просто «подписаться на большее количество источников», а выстроить единое ядро, в которое аккуратно маппятся и нормализуются данные с разных фидов. Зато в перспективе это позволило им предлагать клиентам более гибкий набор лиг и метрик.

Заключение: что делать уже сейчас

Если обобщить, работа с современными спортивными дата-сетами по лигам — это не разовая интеграция, а непрерывный процесс: регулярные обновления, контроль изменений и адаптация графиков к новым метрикам. Самый практичный подход — начать с пилота на ограниченном наборе лиг, построить устойчивый пайплайн, а затем масштабировать и усложнять модели.

В итоге именно устойчивость процессов — от подписки на спортивные дата-сеты и статистику матчей до мониторинга качества данных — определяет, сможете ли вы конкурировать в медиа, аналитике или беттинге. Чем раньше вы заложите техпроцессы под постоянные «новости спортивных дата-сетов», тем проще будет переживать очередные изменения формата турниров, метрик и источников данных.